Технологический прогресс и массовое создание цифровых данных привели к огромному объему информации, которую нужно обрабатывать и анализировать. В связи с этим становится все более важной задача эффективного поиска и категоризации документов.

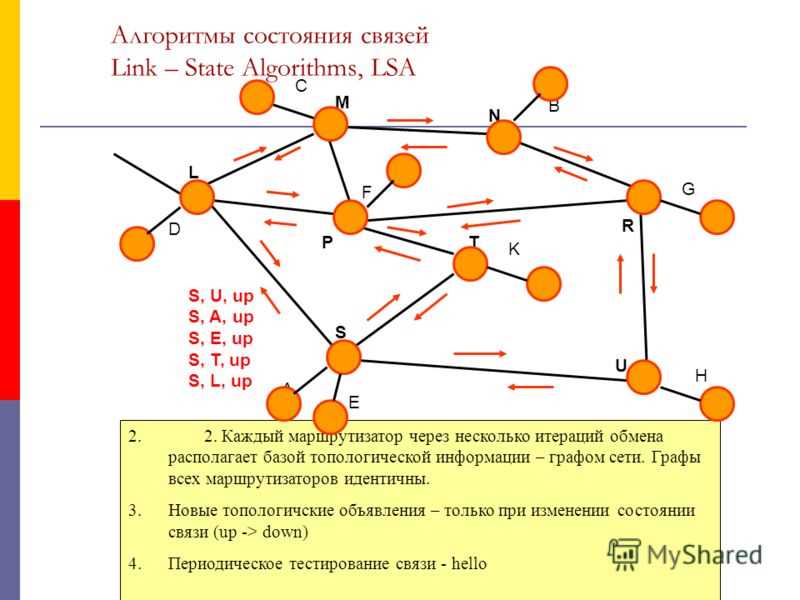

Один из потенциальных решений этой проблемы – алгоритм LSA (латентно-семантический анализ). LSA – это метод обработки естественного языка, который позволяет находить связи и смысловые отношения между словами и текстами.

Принцип работы алгоритма LSA основан на снижении размерности исходной матрицы данных. В основе этого метода лежит идея о том, что семантически близкие документы содержат схожие слова и концепты. LSA позволяет определить эти схожие слова и концепты и снизить размерность матрицы данных путем обнаружения скрытых семантических отношений.

Что такое алгоритм LSA?

LSA работает на основе математических методов, используя матричное разложение по сингулярным значениям (SVD) для снижения размерности пространства слов в документах. В результате применения LSA получается матрица, где каждый документ представлен в виде вектора, а каждое слово — в виде фактора, отражающего его семантическую значимость.

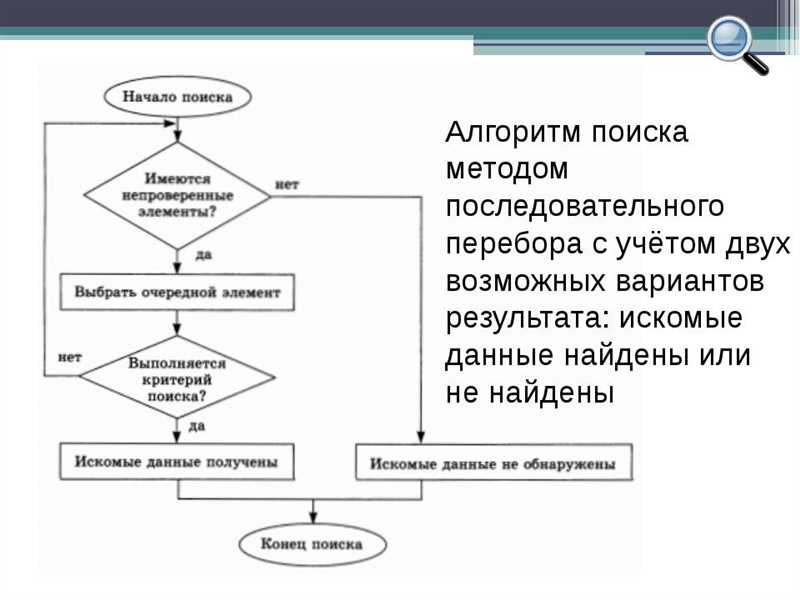

Для поиска похожих документов алгоритм LSA сравнивает семантическое подобие между векторами документов. Можно использовать косинусное расстояние или другие метрики для оценки сходства. После этого можно ранжировать документы по степени их схожести и предоставить пользователю наиболее релевантные результаты.

Преимуществом алгоритма LSA является его способность обрабатывать большие объёмы текстовой информации и учитывать семантическое значение слов. Он широко применяется в поисковых системах, анализе текстов и рекомендательных системах для повышения точности и эффективности.

Принцип работы алгоритма LSA

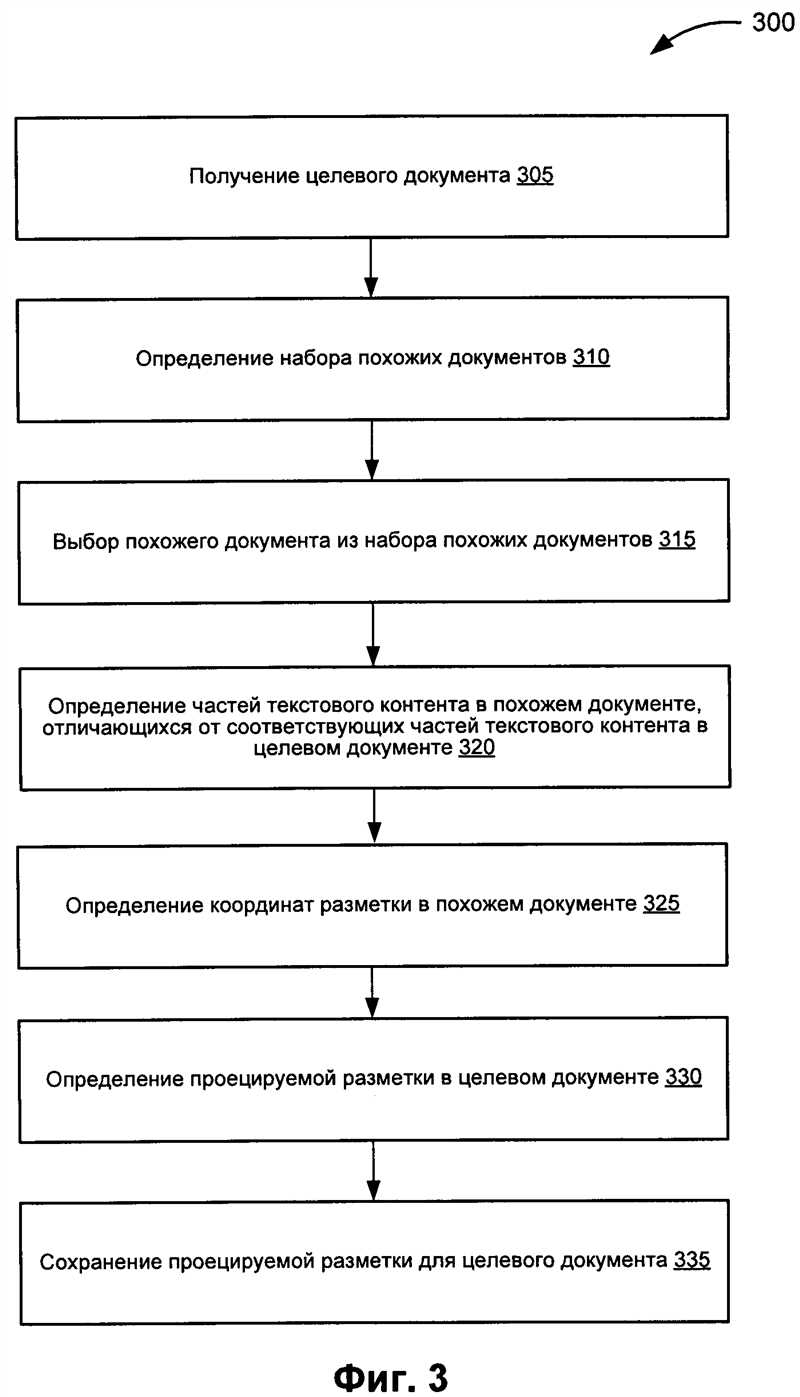

Процесс работы алгоритма LSA можно разделить на несколько шагов. Сначала мы создаем матрицу термин-документ (term-document matrix), в которой строки соответствуют терминам, а столбцы — документам. Затем проводим лемматизацию и удаление стоп-слов для каждого документа, чтобы получить базовые термины. Далее применяем векторизацию для преобразования текстовых документов в числовые векторы, используя TF-IDF (term frequency-inverse document frequency) или другие методы.

После представления документов в виде числовых векторов мы применяем сингулярное разложение (SVD) для матрицы термин-документ. SVD позволяет разложить матрицу на три компонента: матрицу левых сингулярных векторов, матрицу сингулярных значений и матрицу правых сингулярных векторов. Затем мы выбираем наиболее значимые компоненты, которые объясняют наибольшую часть дисперсии, и используем их для поиска похожих документов.

Алгоритм LSA позволяет учитывать семантическую связь между терминами и документами, даже если они не содержат одинаковых слов. Это делает алгоритм LSA эффективным для поиска похожих документов и терминов в большом объеме текстовой информации.

Применение алгоритма LSA в поиске похожих документов

Применение LSA в поиске похожих документов состоит из нескольких шагов. Сначала происходит предобработка текстовых данных, включающая токенизацию, удаление стоп-слов и другие операции для повышения качества анализа. Затем тексты представляются в виде матрицы термин-документ, где каждому термину и каждому документу соответствует определенное значение.

Далее применяется сингулярное разложение матрицы, которое позволяет сократить размерность данных и выделить латентные семантические признаки. Эти признаки используются для определения схожести между документами. Чем больше общих латентных признаков у двух документов, тем более похожими они считаются.

Преимуществами использования алгоритма LSA в поиске похожих документов являются:

- Высокая скорость обработки больших массивов текстовых данных.

- Учет смысловой близости слов, а не только их повторяемости.

- Минимизация проблем с синонимами и омонимами.

- Устойчивость к шуму и вариациям в текстовых данных.

Наши партнеры: